Összefoglalás

Az utóbbi évek technológiai fejlődése számos iparágban új megoldásokat hozott. Az egyik ilyen gyorsan fejlődő terület az AI (MI), vagyis az Artifical Intelligence (Mesterséges Intelligencia) által végzett képgenerálás, amely számos területen forradalmasította a kreatív folyamatokat. Az alábbiakban vázlatosan bemutatjuk az AI képgenerálás kezdeteit, a jelenleg használatos eszközöket, és egy pillantást vetünk a lehetséges jövőre illetve a videózásban várható fejlődési lehetőségekre is kitérünk kicsit.

Az AI képgenerálás kezdetei

Bár a mesterséges intelligencia segítségével történő képgenerálásra tett legkorábbi kísérletek az 1970-es évekre nyúlnak vissza, évtizedekig nem történt jelentősebb előrelépés ezen a területen. A rendelkezésre álló számítási teljesítmény és adatmennyiség korlátozott volt, az algoritmusok pedig túl egyszerűek és merevek voltak ahhoz, hogy bonyolultabb és valósághűbb képeket kezeljenek.

GAN

Ez a helyzet azonban a mélytanulás és a neurális hálózatok megjelenésével kezdett megváltozni, ezen tudás megalapozta a generatív adverzális hálózatok kifejlesztését (GAN).

A GAN-ok jelentős áttörést jelentettek a mesterséges intelligencia által generált képek, audiovizuális anyagok területén. Ezt a neurális hálózati architektúrát 2014-ben Ian Goodfellow és kollégái fejlesztették ki a Montreali Egyetemen. Két neurális hálózatból áll: egy generátorból és egy diszkriminátorból, amelyeket váltakozó periódusokban tanítanak. A generátorhálózat megtanul olyan szintetikus adatokat generálni, amelyek utánozzák a valós adatok eloszlását, míg a diszkriminátorhálózat megtanul különbséget tenni a generátor által generált szintetikus adatok és a valós adatok között.

A képzési folyamat iteratív, a generátor megpróbál olyan szintetikus adatokat előállítani, amelyek megtéveszthetik a diszkriminátort, a diszkriminátor pedig javítja a valós és hamis adatok megkülönböztetésének képességét.

A végeredmény egy olyan generátor, amely képes olyan szintetikus adatokat előállítani, amelyek vizuálisan vagy hallhatóan megkülönböztethetetlenek a valós adatoktól. Ez az általános megközelítés nem csak képszintézisre, hanem más feladatokra, például stílusátvitelre vagy data augmentation-ra (a tanításhoz használt adatok mesterséges bővítése a meglévő adatok módosított változataival (vagy AI által létrehozott adatokkal) is használható, és a vizuális tartományon kívül is alkalmazható, például hanggenerálásban, például zene szintézisében.

Ez a megközelítés sikeresnek bizonyult a jó minőségű képek generálásában, és számos helyen, például arcok, tájak és tárgyak képének generálásában használták. A GAN-okat emellett más feladatokra is adaptálták, például részletes képek generálására durva vázlatokból, egy kép stílusának átvitelére egy másik képre, vagy egy kép töredékeinek a kívánt objektummal való helyettesítésére.

Bár a GAN-ok lenyűgöző eredményeket mutattak a valósághű képek előállításában, ennek a technológiának számos korlátja van. Az egyik ilyen korlátozás a képzési folyamat instabil jellege. A hálózat ellentmondásos szerkezete olyan összeomláshoz vezethet, amikor a generátorhálózat csak korlátozott számú képet állít elő, amelyek nem fedik le a lehetséges kimenetek teljes skáláját, így a kimeneti képek sokféleségének hiánya lép fel.

Az overfitting egy másik probléma, amelyre a GAN-ok különösen érzékenyek lehetnek, amikor a generátorhálózat megjegyzi a képzési adathalmazt ahelyett, hogy általánosítaná azt, hogy új képeket állítson elő. Emellett a GAN-ok a számítási komplexitás miatt nehezen tudnak nagy felbontású képeket generálni, mivel gyakran jelentős mennyiségű időt és számítási teljesítményt igényel a képzésük.

Ráadásul, bár vannak példák a GAN-ok szöveg-kép verzióira vagy a kép-kép fordítást végző modellekre, a legtöbb implementáció korlátozott ellenőrzést biztosít a generált kimenet felett, ami kihívássá teszi a konkrét objektumok előállítását vagy a generált képek stílusának megváltoztatását jelentős további képzés vagy manipuláció nélkül.

Megjelent a DALL-E

Ezen korlátok leküzdése érdekében a kutatók folytatták a képek előállítására szolgáló új megoldások fejlesztését, és megjelent 2021 január 5.-ikén az OpenAI által kifejlesztett DALL-E (a hármas verzió elérhető itt). A modell a Generative Pre-trained Transformer-t használta, amely viszont a korábbi transzformátor-modellen alapul. Mindkettőt eredetileg természetes nyelvi feldolgozásra fejlesztették ki.

A Transformer modell egy neurális hálózati architektúra, amely egy önfigyelési mechanizmuson alapul. A hagyományos neurális hálózatokban minden egyes bemeneti elemet egymástól függetlenül dolgoznak fel, ami nehézségekhez vezethet a hosszú távú függőségek modellezésében. A figyelemmechanizmus lehetővé teszi, hogy a modell szelektíven a bemeneti szekvencia különböző részeire fókuszáljon, így képes a szavak közötti összetett kapcsolatok megragadására.

A Transformer Modell egy kódolóból és egy dekódolóból áll, amelyek mindkettő több rétegű önfigyelő és előrecsatolt neurális hálózatokból áll. A modell nagymértékben párhuzamosítható, és számos természetes nyelvfeldolgozási feladatban a legkorszerűbb eredményeket érte el.

Ezen architektúra alapján a Generative Pre-trained Transformers-t eredetileg 2018-ban fejlesztette ki az OpenAI. A GPT úgy működik, hogy egy nagyméretű semleges hálózatot képez ki hatalmas mennyiségű szöveges adatra, például könyvekre, cikkekre és weboldalakra. A modell egy felügyelet nélküli tanulásnak nevezett folyamatot használ, oly módon, hogy az adatokban mintákat és kapcsolatokat azonosít, viszont anélkül, hogy kifejezetten megmondanák neki, mik ezek a minták.

Ha a modell be van tanítva, új szövegek létrehozására használható a következő szó vagy szósorozat megjóslásával a mondatban lévő előző szavak kontextusa alapján. Ez egy autoregressziónak nevezett folyamat segítségével történik, ahol a modell egyszerre egy-egy szót generál, a következő szó valószínűségi eloszlása alapján, az előző szavak ismeretében.

Az eredeti GPT-t 2019-ben, majd 2020-ban ismét felskálázták, így jött létre a GPT-3, amely 175 milliárd paramétert használ. Ez a modell lett az alapja a DALL-E-nek, amely 12 milliárd paramétert használó multimodális megvalósítását használja, amely az internetről származó szöveg-kép párokra eső szöveget pixelekre cseréli.

A DALL-E modell kiemelkedő eredményeket mutatott a szöveges bemeneti adatokon alapuló képgenerálás több feladatában. Amellett, hogy a modell egyszerűen mintaképeket generál a különböző tárgyakról, amelyeket a képzés során látott, képes a különböző ötletek integrálására és a nem kapcsolódó fogalmak meggyőző módon történő összekapcsolására, még olyan tárgyakat, képeket is létrehozva, amelyek létezése a fizikai világban valószínűtlen vagy egyáltalán nem lehetséges.

A CLIP, BigSleep, és egyéb modellekről – mint például a diffúz modellekről – vagy egyéb modellekről – például Midjourney – most nem írunk részletesebben.

A jelen

A DALL-E 3

2023 szeptemberében az OpenAI bejelentette legújabb képmodelljét, a DALL-E 3-at, amely „lényegesen több árnyalat és részlet megértésére” képes, mint a korábbi verziók.

A DALL-E 3 már elérhető minden ChatGPT felhasználó számára, valamint a fejlesztők számára az API-n keresztül is. A modern szöveg-kép rendszerek hajlamosak figyelmen kívül hagyni a szavakat vagy a leírásokat, így a felhasználók kénytelenek megtanulni a prompt technikát. A DALL-E 3 ugrásszerű előrelépést jelent a megadott szöveghez pontosan illeszkedő képek generálásában.

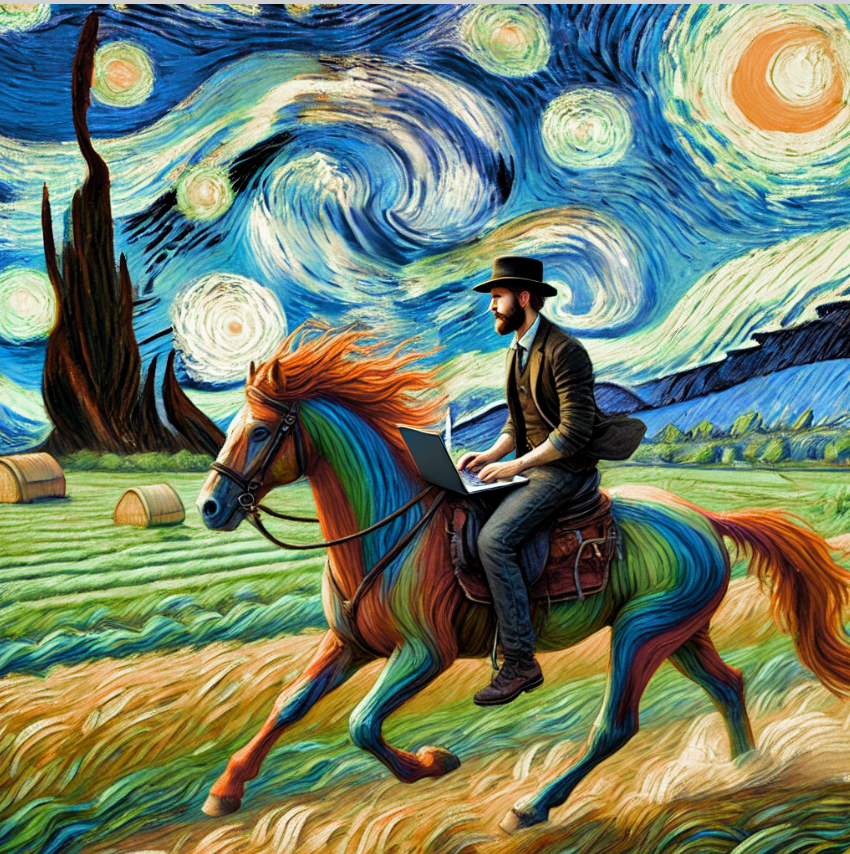

Például egy lovagló webfejlesztő így néz ki, Van Gogh stílusában megfestve:

Űrhajós pingvin ünnepli az új évet:

A jövő

Az AI képgenerálás folyamatosan, rendkívül gyorsan fejlődik. Az egyik legérdekesebb terület, egyre pontosabb és élethűbb képek generálása egyre egyszerűbb lesz. Néhány előrejelzés, sejtés következik, merre történhet a fejődés:

Személyreszabott képek generálása

A jövő egyik nagy ígérete az, hogy az AI által generált képeket teljesen egyénre szabhatjuk. Ez különösen a marketingben lehet forradalmi, ahol a vásárlók személyre szabott vizuális élményekkel találkozhatnak a reklámokban és termékbemutatókban.

Virtuális Valóság és AI

A virtuális valóság és az AI kombinációja szintén hatalmas lehetőségeket rejt magában. Az AI képes lesz virtuális világokat létrehozni, amelyeket a felhasználók szabadon felfedezhetnek, és akár valós időben is generálhat képeket a felhasználó interakciói alapján.

Ilyen játékon máris fejlesztett az AI, itt egy érdekes cikk erről.

FRISSÍTÉS:

Megjelentek új modellek, toolok, mint például ComfyUI vagy a Nano Banana. A Nano Banana a Google jelenleg (2025 vége / 2026 eleje) legmodernebb képgeneráló modellje, amely a szövegből történő képalkotás mellett fejlett szerkesztési funkciókat is kínál. Képes meglévő képek módosítására, több forrásból álló kompozíciók létrehozására, valamint kiemelkedik a képeken belüli precíz szövegmegjelenítésben. Legnagyobb előnye az iteratív finomítás: a felhasználók egyszerű párbeszéd útján, lépésről lépésre alakíthatják és tökéletesíthetik a vizuális végeredményt.

Etikai Kihívások

Természetesen az AI képgenerálás jövőjével kapcsolatosan etikai kérdések is felmerülnek, mint például a szerzői jogok és a mesterségesen előállított tartalmak hitelessége. Ahogy egyre élethűbbé, a valóságtól megkülönböztethetetlenné válnak ezek a képek, a jogi és társadalmi szabályozásoknak is alkalmazkodniuk kell. Valószínűleg ezen a területen még sok kihívással kell megküzdeniük nem csak az IT hanem a jogi területen tevékenykedő szakembereknek..

Amennyiben szeretne a témában tanulni, megoldásra van szüksége, üzemeltetési problémája van vagy egyedi informatikai témában segítségre van szüksége (akár egy RAG rendszer kialakítása érdekli), keressen fel.

Képek:

OpenaAI weboldal

DALL-E által generált